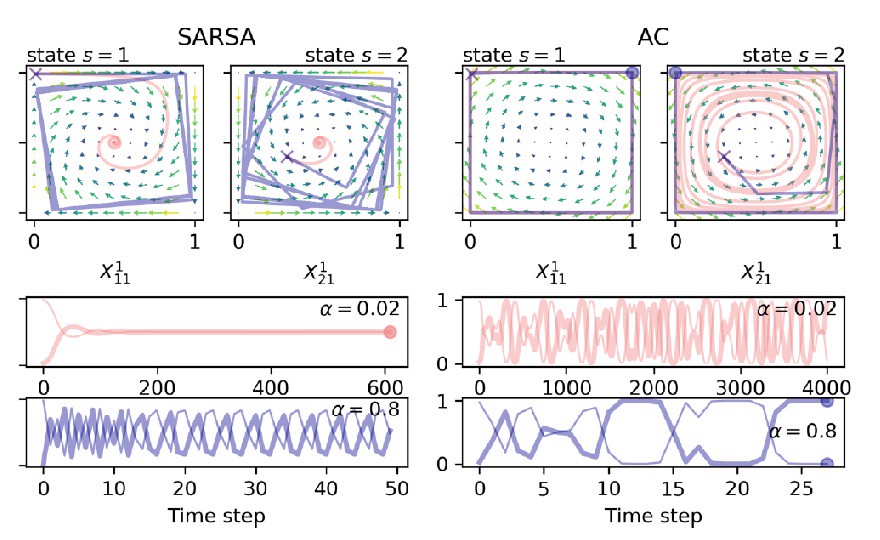

„Mit unserer Arbeit tragen wir dazu bei, besser zu verstehen, welche Auswirkungen künstliche Intelligenz auf die Gesellschaft haben kann. Mit Techniken aus der Theorie der dynamischen Systeme stellen wir fest, dass sich selbstlernende Agenten möglicherweise nicht in der Weise entwickeln, dass sie eine einzige Verhaltensweise an den Tag legen. Stattdessen können sie in einen kontinuierlichen Zyklus verschiedener Verhaltensweisen eintreten oder sich sogar auf eine unvorhersehbare Weise entwickeln", erklärt Hauptautor Wolfram Barfuß. „Künftig können die Erkenntnisse aus solchen dynamischen Systemstudien dann dazu dienen, um das Design groß angelegter KI-Systeme des verstärkenden Lernens zu verbessern."

Eines der Elemente, die die Studie von früheren Forschungen unterscheiden, ist die Rolle der Umgebung des Modells. Frühere Forschungen begrenzten die Variabilität der Umgebung der Agenten. In Wirklichkeit entwickeln sich Umgebungen jedoch dynamisch und die Agenten passen ihr Verhalten entsprechend an. „Wir präsentieren eine methodische Erweiterung: Durch die Trennung der Interaktions- von der Anpassungszeitskala erhalten wir einen deterministischen Grenzübergang einer allgemeinen Klasse von Verstärkungslernalgorithmen. Dies wird als zeitliches Differenzlernen (temporal difference learning) bezeichnet. Diese Form des Lernens funktioniert in der Tat in realistischeren und vielgestaltigeren Umgebungen", sagt Jürgen Kurths, Mitautor und Vorsitzender des Forschungsbereichs Komplexitätswissenschaften am Potsdam-Institut.

Künstliche Intelligenz hat auch ein großes Potenzial für das Verständnis von Klimaauswirkungen. So zielt das Potsdam-Institut darauf ab, den Einsatz künstlicher Intelligenz zu erhöhen, um z.B. zu bewerten, wie Menschen möglicherweise auf Schocks durch den Klimawandel reagieren. Dies könnte dazu beitragen, die Öffentlichkeit in Zukunft besser vor solchen Risiken zu schützen.

Artikel: Wolfram Barfuss, Jonathan F. Donges, Jürgen Kurths (2019): Deterministic limit of temporal difference reinforcement learning for stochastic games. Phys.Rev. E 99 [DOI: 10.1103/PhysRevE.99.043305]

Weblink zum Artikel: https://journals.aps.org/pre/abstract/10.1103/PhysRevE.99.043305#fulltext